L’intelligence artificielle générative bouleverse la création de contenus et pose des questions inédites en matière de droit d’auteur et de propriété intellectuelle. En 2025, les œuvres générées par IA représentent une part croissante des productions culturelles et commerciales, mais leur statut juridique reste incertain. Cet article explore les enjeux clés, les risques pour les entreprises et les pistes de solutions concrètes.

Le droit d’auteur face à l’autonomie algorithmique

L’exigence d’une paternité humaine

En France, comme dans la plupart des juridictions, le droit d’auteur repose sur la notion d’originalité humaine. Une œuvre doit porter l’empreinte de la personnalité de son auteur pour être protégée (article L.112-2 du Code de la propriété intellectuelle). Les créations entièrement générées par une IA sont donc exclues de cette protection.

L’affaire Thaler v. Perlmutter (2023) aux États-Unis a confirmé que les œuvres produites exclusivement par une IA ne peuvent pas bénéficier du copyright. Cette décision a été réaffirmée dans le rapport 2025 du Copyright Office américain, qui distingue clairement œuvres assistées par IA et œuvres autonomes générées par IA.

Œuvres hybrides : où commence la protection ?

La frontière entre assistance et autonomie est au cœur des débats juridiques :

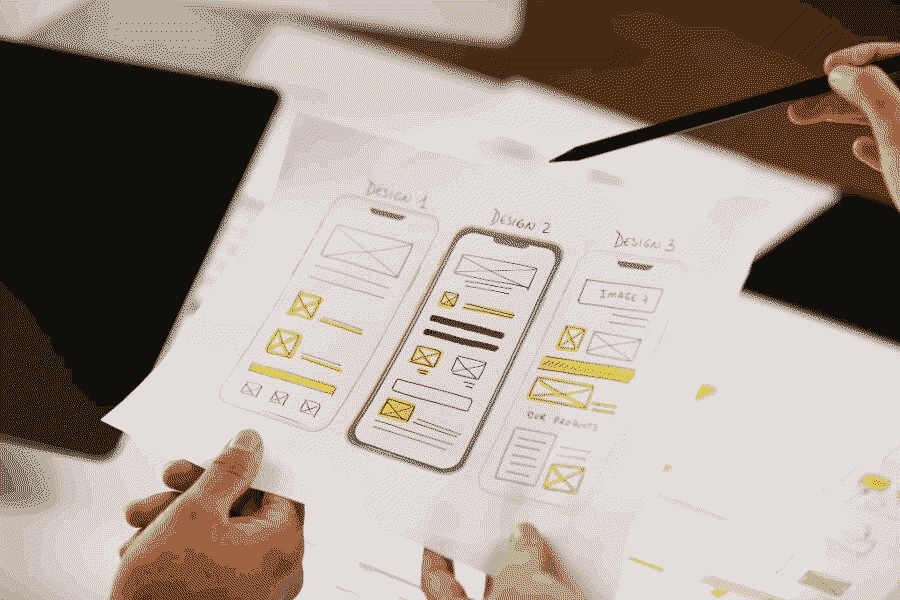

- Œuvres assistées par IA : si un humain utilise une IA comme outil pour enrichir ou modifier une création, l’œuvre peut être protégée si l’intervention humaine est significative. Par exemple, un designer qui utilise Midjourney pour générer des esquisses puis les retravaille peut revendiquer des droits sur la version finale.

- Œuvres autonomes : les contenus produits sans intervention humaine directe tombent dans le domaine public, car ils ne remplissent pas les critères d’originalité humaine.

Cette distinction crée une zone grise juridique pour les entreprises exploitant des outils d’IA générative.

Les risques juridiques liés aux données d’entraînement

L’utilisation non autorisée de contenus protégés

Les modèles d’IA générative, comme DALL·E ou Stable Diffusion, s’appuient souvent sur des bases de données contenant des œuvres protégées par le droit d’auteur. En janvier 2023, Getty Images a intenté une action en justice contre Stability AI devant la High Court of Justice au Royaume-Uni, alléguant que l’entreprise avait utilisé 12 millions d’images protégées sans autorisation pour entraîner son modèle Stable Diffusion.

Une entreprise utilisant un modèle entraîné sur des données protégées peut être tenue responsable en cas de contrefaçon si elle exploite commercialement des contenus générés qui enfreignent le droit d’auteur. Cependant, cette responsabilité dépend du contexte et du degré de connaissance ou de négligence de l’utilisateur concernant l’origine des données utilisées par le modèle.

L’affaire Ultraman en Chine

Dans l’affaire Ultraman (2024), un tribunal chinois a jugé que le fournisseur de services IA était responsable pour avoir permis à ses utilisateurs de générer des images similaires à des personnages protégés sans prendre les mesures nécessaires pour empêcher ces violations.

Le tribunal a retenu plusieurs éléments :

- Manque de prévention : le fournisseur n’avait pas mis en place de filtres ou avertissements juridiques pour limiter les violations potentielles.

- Profit économique direct : la plateforme bénéficiait financièrement des activités liées à ces contenus.

- Responsabilité technique : en tant qu’opérateur technique, le fournisseur avait un contrôle sur les outils utilisés.

Dans ce cas précis, les utilisateurs n’ont pas été poursuivis, car la plateforme était considérée comme ayant une responsabilité accrue en raison de son rôle actif dans la fourniture et le fonctionnement du service.

Stratégies juridiques et techniques pour sécuriser l’innovation

Clauses contractuelles adaptées

Les entreprises doivent intégrer dans leurs contrats avec les fournisseurs d’IA des clauses garantissant la légalité des données utilisées :

- Garantie de provenance : certificat attestant que les datasets utilisés sont exempts de contenus protégés non autorisés.

- Clause de réversion : transfert automatique des droits en cas de litige lié à une œuvre générée par IA.

Ces clauses permettent de limiter les risques juridiques tout en clarifiant la responsabilité en cas de contentieux.

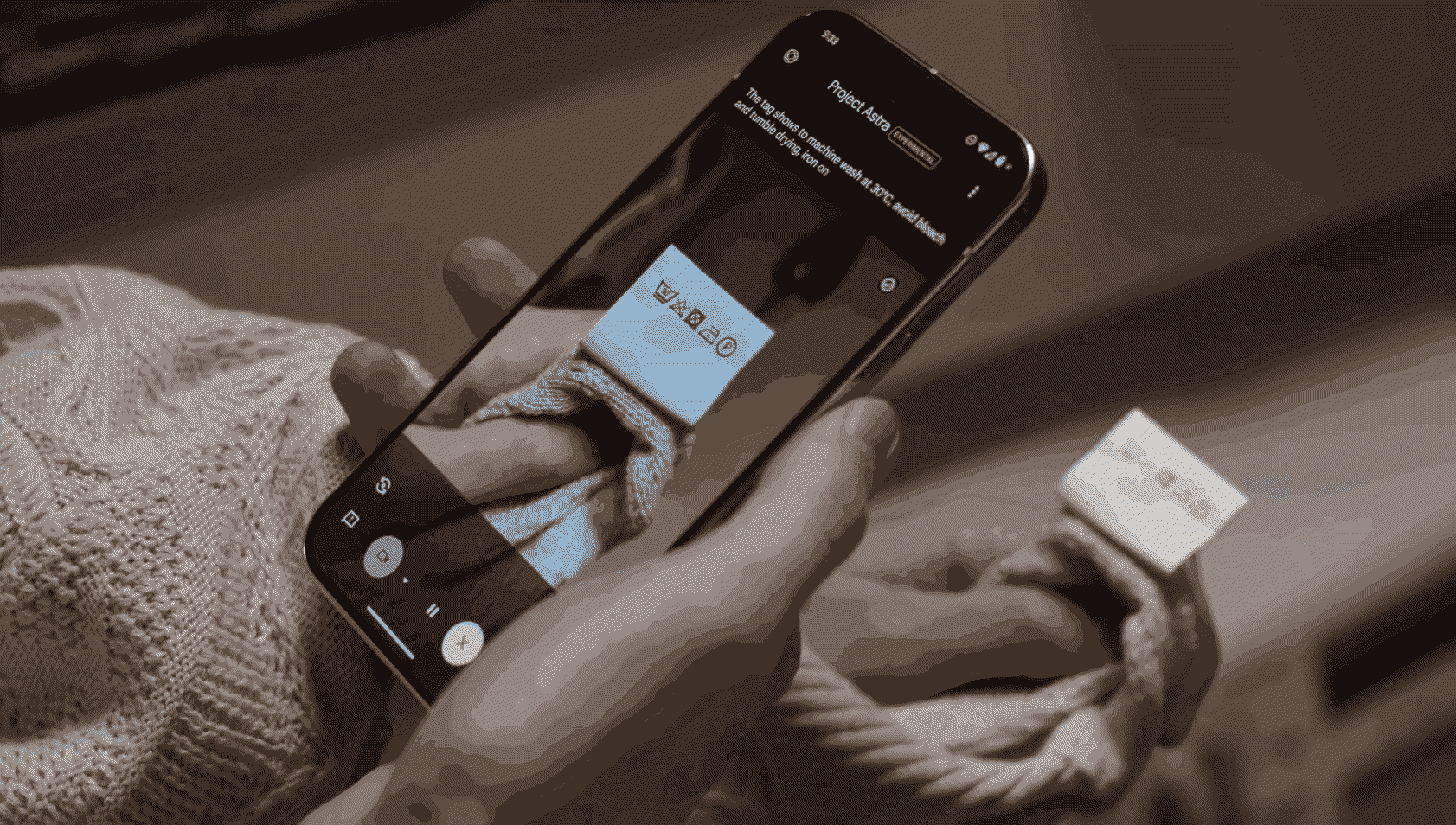

Solutions technologiques innovantes

Pour garantir la traçabilité des œuvres générées par IA, plusieurs outils émergent :

- Watermarking invisible : intégration d’une signature numérique dans les contenus créés par IA pour prouver leur origine et leur authenticité.

- Blockchain : création d’un registre immuable permettant de documenter chaque étape du processus créatif, incluant les contributions humaines et algorithmiques.

Ces technologies réduisent significativement le risque de litiges tout en facilitant la gestion des droits sur les œuvres hybrides.

Évolutions législatives et perspectives futures

L’IA Act européen : un cadre contraignant mais nécessaire

Adopté en juillet 2024 et entré en vigueur le 1er août 2024, ce règlement marque le début d’une transition vers une régulation plus stricte de l’intelligence artificielle. Cependant, son application est progressive afin de permettre aux entreprises et autorités européennes de s’adapter aux nouvelles exigences.

Voici les principales étapes :

- 2 février 2025 : interdiction des systèmes présentant un risque inacceptable (comme la surveillance biométrique).

- 2 août 2025 : application étendue aux systèmes généralistes.

- 2 août 2026 : mise en conformité complète pour les systèmes à haut risque.

- 2 août 2027 : application totale aux composants critiques liés à la sécurité.

Ces mesures imposent aux développeurs et utilisateurs d’IA :

- Une transparence totale sur les données utilisées pour entraîner leurs modèles ;

- Des licences collectives obligatoires pour rémunérer les ayants droit dont les œuvres ont été utilisées dans l’entraînement ;

- Des audits annuels réalisés par des organismes certifiés.

Bien que contraignant, ce cadre vise à protéger les créateurs tout en encourageant l’innovation technologique responsable.

Missions du CSPLA sur l’IA générative

La ministre de la Culture a mandaté le Conseil supérieur de la propriété littéraire et artistique (CSPLA) pour deux missions essentielles :

- Identifier les informations que les fournisseurs d’IA doivent rendre publiques pour garantir la transparence prévue par le règlement européen.

- Proposer des mécanismes assurant aux ayants droit une protection effective lors de l’utilisation de leurs œuvres par des systèmes d’IA générative.

Ces travaux, menés par Alexandra Bensamoun, Frédéric Pascal et Joëlle Farchy, visent à renforcer le respect des droits d’auteur dans un contexte où les données protégées sont massivement utilisées pour entraîner des modèles d’IA. Les conclusions sont attendues courant 2025.

Questions clés pour les entreprises face aux défis de l'IA

Puis-je breveter une invention co-créée avec l’IA ?

Oui, à condition que la contribution humaine soit déterminante dans le processus inventif. Les offices européens exigent un rapport détaillant clairement les apports respectifs du créateur humain et du modèle algorithmique utilisé.

Comment protéger mes prompts ?

Les prompts peuvent être protégés s’ils démontrent une originalité littéraire ou technique significative (exemple : un scénario interactif détaillé). Les instructions génériques ne sont pas éligibles au droit d’auteur.

Quelles assurances souscrire contre les risques liés à l’IA ?

Privilégiez des contrats d’assurance adaptés couvrant :

- Responsabilité civile contrefaçon : protection en cas de litiges liés à des violations de droits d’auteur ou de propriété intellectuelle.

- Pertes liées au retrait forcé de contenus litigieux : couverture des coûts associés au retrait ou à la modification de contenus générés par IA qui enfreindraient des droits existants.

- Confidentialité et sécurité des données : protection contre l’utilisation abusive ou le détournement des informations sensibles fournies à l’IA, notamment dans un contexte commercial.

L’intégration croissante de l’intelligence artificielle dans les processus créatifs impose aux entreprises une vigilance accrue sur leurs pratiques juridiques et techniques. Adopter dès aujourd’hui des stratégies proactives permettra non seulement de limiter les risques mais aussi de valoriser leurs innovations dans un cadre légal sécurisé.

L'image d'illustration de cet article a été générée par l'IA Reve.